【スマート農業技術】

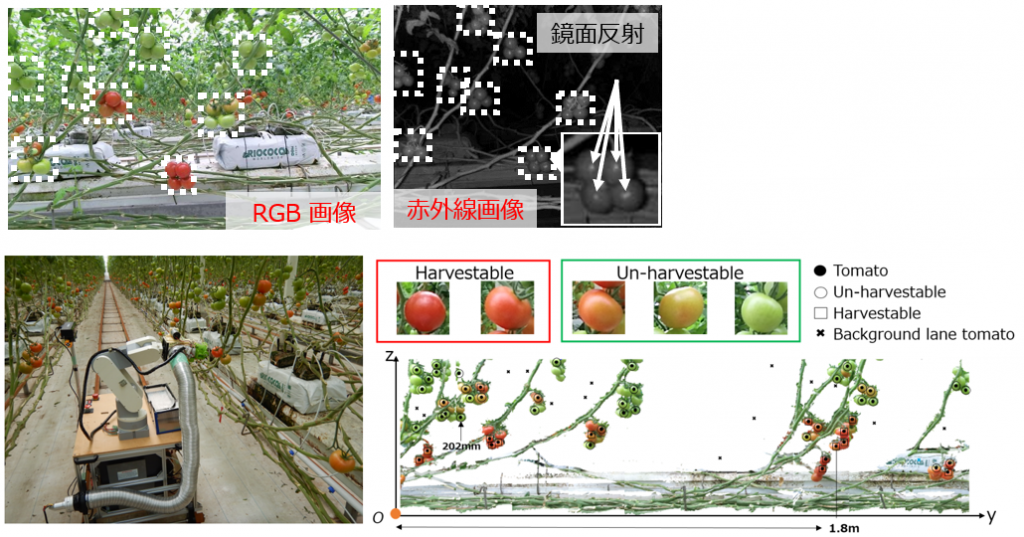

1. 農作物収穫・観測ロボットの知能化技術

[概要]

農業就業者の減少から、 ロボットによる 農業効率化技術の開発が望まれています。農作物は規格化された工業部品とは異なり、全て異なる形状をしている自然物であり、それに対応する技術開発が必要となります。本研究室ではまずトマト果実の収穫ロボットを本学社会ロボット具現化センターが主催しているトマトロボット競技会に参加しながら開発を進めております。

課題やキーワード :

RGB-Dカメラ情報からエンドエフェクタ機能に合わせた アフォーダンス情報(トマトの刈り取り可能性情報)の抽出、トマトの収穫戦略、菜園の時空間画像情報からの収量予想技術、フェノタイピング、3次元点群処理 etc…

2. 農作物の状態と農場環境情報の時空間観測システム

[概要]

農作物の持続的・安定的な供給のために従来の経験と勘の農業から、データに基づいた「スマート農業」への転換が求められています。これまでの農業では農場の気候や土壌の状態、もしくは予め参考となる作物の葉や作物の外観を作業員が確認することによって、大まかに各工程に取り掛かる時期を予想してきました。本研究では生育条件と植物体の状態の両方の情報を統合・解析することで新たな収量予想法の提案し、農場で実証試験を行います。

【水中計測・水中ロボット技術】

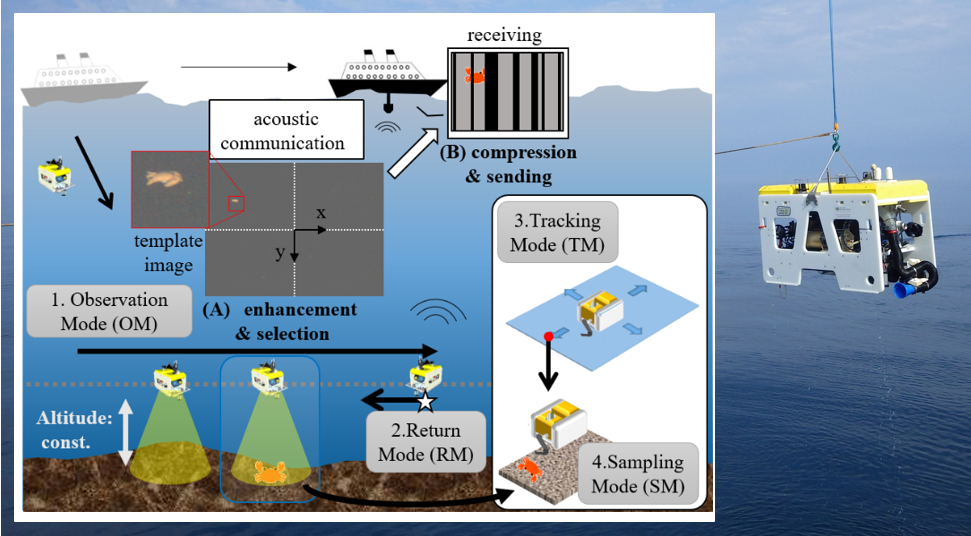

1. サンプリングAUVの知能化技術

[概要]

水産資源や生物学の学術的知見の蓄積のために海洋生態系を調査する技術の開発や運用手法は重要です。我々のグループでは海底物を採取する新たな自律型海洋ロボットである「サンプリングAUV(Autonomous Underwater Vehicle)」の構築に取り組んでいます。サンプリングAUVに優れた海底の様子の観測機能や海底物採取機能を実装するために、本研究室では水中画像の青かぶれを補正する技術や採取対象物をトラッキングする技術等、様々なタスクに対する画像センシング手法やそれを組み込み実装する手法を研究しています。

課題やキーワード :

水質や照明に順応した画像取得カメラ開発、Sampling-AUV、水中画像補正法、水中音響通信用画像圧縮法、水中生物画像トラッキング法、visual SLAM、音響通信技術、統合ソフトウェア 設計法 etc…

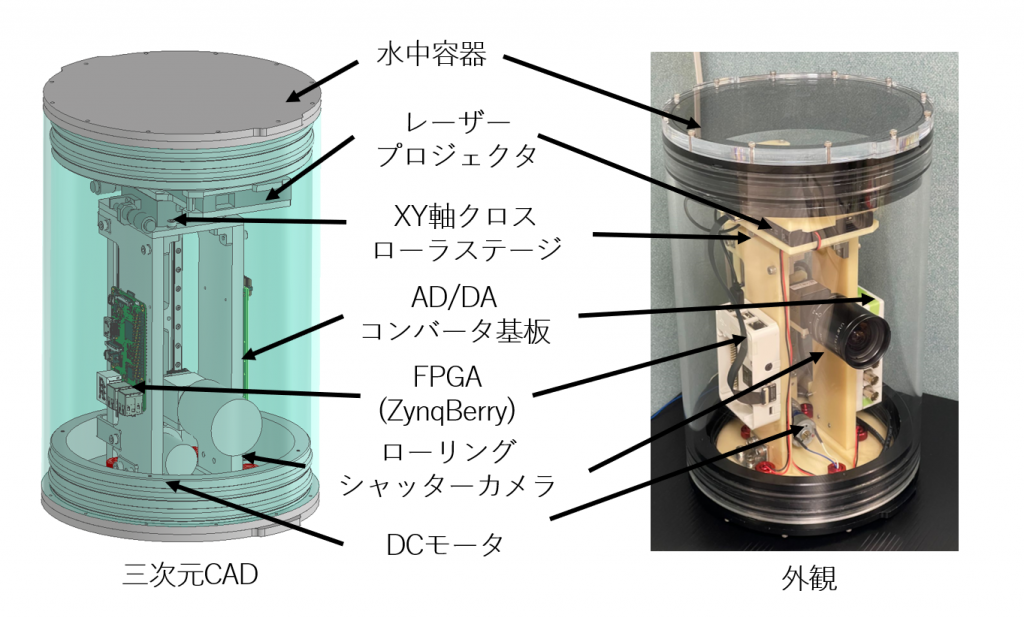

2. 水中用時間同期式プロジェクターカメラシステムの開発

[概要]

濁水環境下においても鮮明な画像を撮影できるビジョンシステムを開発しています。